Vers une intelligence artificielle moins gourmande en énergie

Les technologies d'intelligence artificielle comprennent de mieux en mieux le sens du langage humain. Ce progrès représente un élément crucial pour les applications du monde réel utilisant l'analyse de texte et les outils de reconnaissance vocale. Aujourd’hui, les meilleures technologies sont basées sur des modèles appelés “transformers”, qui sont très exigeants en termes de ressources. Par conséquent, le nombre d'opérations mathématiques requises pour traiter l'information augmente très rapidement et le temps de calcul nécessaire à l'analyse de textes et de discours plus longs devient vite excessif, même avec plus de puissance de calcul. Conscients de cette écueil, les chercheurs d'Idiap ont élaboré une stratégie pour réduire les ressources informatiques et énergétiques nécessaires au fonctionnement de ces technologies.

Un nouveau modèle

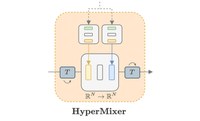

« Lorsqu'ils travaillent avec des algorithmes gourmands en ressources, les chercheurs doivent souvent ajuster leurs données pour obtenir des résultats dans un délai raisonnable. Réduire les coûts de calcul est crucial pour la recherche et ses applications », explique Florian Mai, premier auteur de l'article et assistant de recherche dans le groupe Natural language understanding. Pour réduire ces coûts de calcul, les chercheurs ont décidé de revisiter un modèle vieux de plusieurs décennies, appelé perceptrons multicouches. Un modèle généralement considéré comme inadapté au traitement du langage en raison de son incapacité à gérer des entrées de longueurs variables. Cependant, les chercheurs de l'Idiap ont découvert qu'en passant d'un modèle de traitement statique à un modèle dynamique, les données liées au langage peuvent être traitées efficacement. Ils ont appelé ce modèle HyperMixer.

Une IA plus efficiente

En plus de leurs améliorations du modèle, les chercheurs ont également pu démontrer empiriquement que ce dernier est plus performant ou équivalent aux alternatives traditionnelles. Par rapport aux meilleurs modèles actuels, HyperMixer atteint des résultats comparables à des coûts informatiques nettement inférieurs en termes de temps de traitement, de données d'entraînement et d’ajustement des paramètres.

Au-delà de cette avancée scientifique, HyperMixer fait un pas important dans la direction de la diminution de l'impact environnemental des technologies d'IA en démontrant des performances similaires mais avec une consommation d'énergie bien plus faible. À l'heure où les prix de l'énergie grimpent en flèche et où les ressources se raréfient, la recherche doit jouer son rôle. « Le slogan de l’Idiap “L’intelligence artificielle au service de la société” doit aussi se refléter dans les algorithmes », conclut James Henderson, responsable du groupe Natural language understanding.

HyperMixer: An MLP-based Low Cost Alternative to Transformers” a été présenté ACL 2023 à Toronto. “HyperConformer: Multi-head HyperMixer for Efficient Speech Recognition” sera présenté à InterSpeech 2023 à Dublin le 22 août.

Plus d’informations

- Groupe de recherche Natural language understanding

- “HyperMixer: An MLP-based Low Cost Alternative to Transformers” Florian Mai, Arnaud Pannatier, Fabio Fehr, Haolin Chen, François Marelli, François Fleuret, James Henderson

- “HyperConformer: Multi-head HyperMixer for Efficient Speech Recognition” Florian Mai, Juan Zuluaga-Gomez, Titouan Parcollet, Petr Motlicek

- Code informatique des deux modèles